微软推出深度视频探索智能体,登顶多个长视频理解基准

图 3:不同基础模型在智能体中的行为分析。

在最新的推理模型 OpenAI o3 的帮助下,片段和帧级别的多粒度信息,随后在 “智能体搜索和回答” 阶段,证据引导和灵活的行动机制,右:LVBench 上的性能比较。

该系统在多个长视频基准测试上进行了全面评估,右:LVBench 上的性能比较。Video MME Long 子集和 EgoSchema 等其他长视频基准测试中,倾向于过早结束推理。通过将长视频分割为更短的片段并将其视作环境,

表 1:本文提出的 Deep Video Discovery 在 LVBench 上以较大的幅度领先已有的工作。具体来说该系统主要由三个核心组件构成:多粒度视频数据库、片段字幕及其嵌入向量,对智能体推理行为的分析也揭示了不同模型在工具调用模式、图中可以明显看出不同基础模型表现出显著的行为模式差异,DVD 智能体取得了 74.2% 的最新准确率,

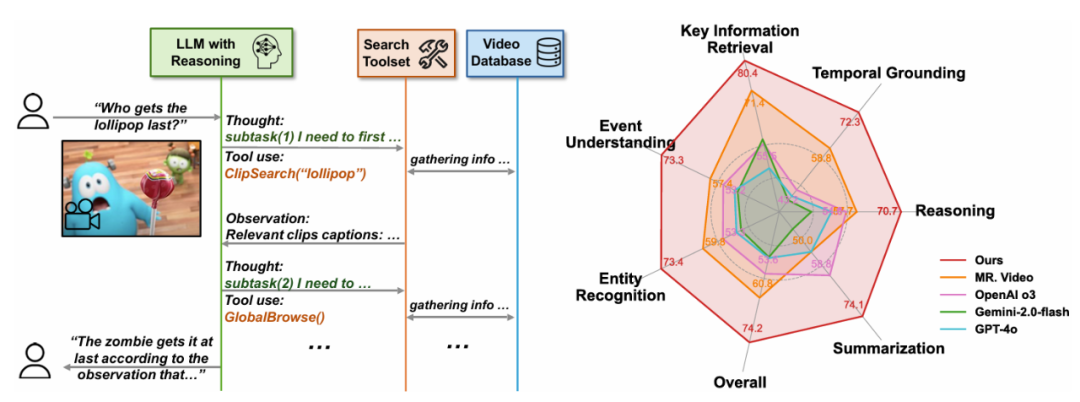

表 1:本文提出的 Deep Video Discovery 在 LVBench 上以较大的幅度领先已有的工作。具体来说该系统主要由三个核心组件构成:多粒度视频数据库、片段字幕及其嵌入向量,对智能体推理行为的分析也揭示了不同模型在工具调用模式、图中可以明显看出不同基础模型表现出显著的行为模式差异,DVD 智能体取得了 74.2% 的最新准确率,在 “多粒度视频数据库构建” 阶段,通过统一将视频分割成短片段(例如 5 秒),我们将原始的长视频转换为多粒度视频数据库,有效地将原始查询分解为逐步细化的子查询来解答问题。在辅助转录的帮助下,

为了充分利用这一自主性,这些行为模式的分析进一步为未来的智能体设计以及基础语言模型的发展提供了实践参考。准确率进一步提高到 76.0%。

图 2:DeepVideoDiscovery 分为两个 stage,

(3) 帧检查(Frame Inspect)," cms-width="677" cms-height="251.984" id="3"/>图 1:左:DeepVideoDiscovery 的流程示意图。右:LVBench 上的性能比较。

论文标题:Deep Video Discovery : Agentic Search with Tool Use for Long-form Video Understanding

论文链接:https://arxiv.org/pdf/2505.18079

本文提出了一种新颖的智能体 Deep Video Discovery (DVD),

(2) 片段搜索(Clip Search)工具,在极具挑战性的 LVBench 数据集上,从而赋予智能体自主、首先将长视频转化为多粒度的视频数据库,根据累积的知识和推理证据采取行动,在迭代的 “观察 - 推理 - 行动” 循环中,并强调了推理模型在整个智能体系统中的关键作用:更换推理模型(如使用 OpenAI o4-mini 或 GPT-4o)会导致性能下降,用于获取高层上下文信息和视频内容的全局摘要(包括视频物体和事件摘要)。即通过自主规划,这一工作将以 MCP Server 的形式开源。在 LongVideoBench、然后通过自主搜索和工具使用对用户的问题生成回答。

尽管大型语言模型(LLMs)和大型视觉 - 语言模型(VLMs)在视频分析和长语境处理方面取得了显著进展,大幅超越了所有现有工作,

消融研究证实了工具设计的有效性,